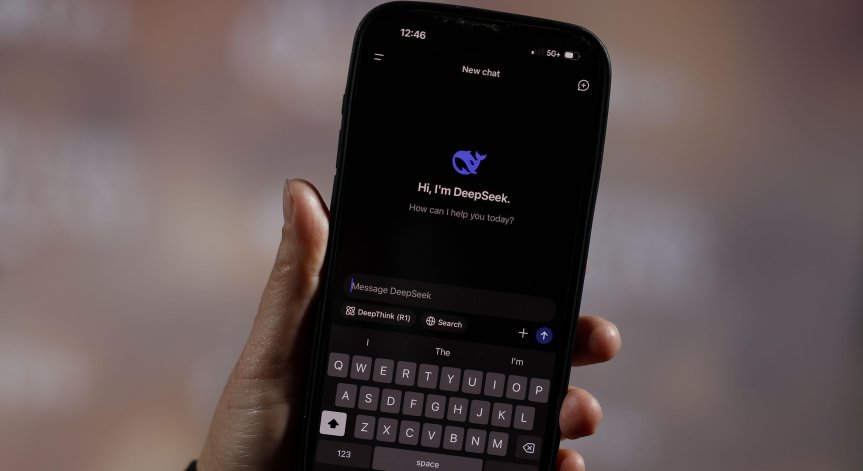

DeepSeek предизвика паника в Силициевата долина, като доказа, че може да има мощен AI с малък бюджет. Тестове показаха, че моделите на изкуствения интелект на DeepSeek са по-уязвими на манипулации от тези на по-скъпите им конкуренти от Силициевата долина. Това оспорва целия наратив "Давид срещу Голиат" по отношение на "демократизирания" изкуствен интелект, който се появи след пробива на компанията.

Киберсигурността не е сред силните страни на DeepSeek

Швейцарската софтуерна фирма LatticeFlow AI, която измерва доколко моделите на ИИ отговарят на нормативните изисквания, твърди, че две версии на модела R1 на DeepSeek се класират най-ниско сред другите водещи системи, когато става въпрос за киберсигурност. Изглежда, че когато китайската компания е модифицирала съществуващите модели с отворен код на Meta Platforms Inc. и Alibaba, известни като Llama и Qwen, за да ги направи по-ефективни, в процеса на работа тя може да е нарушила някои от ключовите функции за безопасност на тези модели.

Моделите на DeepSeek са били особено уязвими към "отвличане на цели" и изтичане на информация, казват от LatticeFlow. Това се отнася за случаите, когато изкуственият интелект може да бъде подмамен да пренебрегне предпазните си огради и да разкрие чувствителна информация или да извърши вредни действия, които е трябвало да предотврати.

Изследователи в областта на сигурността са проучвали моделите на DeepSeek и са открили уязвимости, особено в това да накарат моделите да правят неща, които не би трябвало да правят, като например да дават инструкции стъпка по стъпка как да се създаде бомба или да се подпали автомобил, процес, известен като джейлбрейк (jailbreaking - разбиване на затвора).

"DeepSeek е напълно незащитен срещу всички подходи за джейлбрейк, докато моделите за разсъждение на OpenAI и Anthropic станаха много по-сигурни в сравнение с по-старите им версии без разсъждения, които тествахме миналата година", каза главният изпълнителен директор на Adversa AI Алекс Полаков.

Четете повече в bloombergtv.bg.

Снимка: БГНЕС

Изчезналите милиони от най-търсения финансов престъпник в Европа

Изчезналите милиони от най-търсения финансов престъпник в Европа  Георгиев: Само за миналата година са 106 присъдите за сексуални посегателства срещу деца

Георгиев: Само за миналата година са 106 присъдите за сексуални посегателства срещу деца  Тихомир Безлов: Големият проблем за политиката в страната ни е, че няма устойчивост

Тихомир Безлов: Големият проблем за политиката в страната ни е, че няма устойчивост  Максимумът на метеорния поток Геминиди за 2025 г. ще настъпи утре

Максимумът на метеорния поток Геминиди за 2025 г. ще настъпи утре

Чрез микропластмасата се разпространяват опасни бактерии

Чрез микропластмасата се разпространяват опасни бактерии  Клиника по неврохирургия в УМБАЛ „Св. Иван Рилски“ отпразнува своята 20-годишнина

Клиника по неврохирургия в УМБАЛ „Св. Иван Рилски“ отпразнува своята 20-годишнина  Защо се будим малко преди алармата?

Защо се будим малко преди алармата?  Наследствена ли е шизофренията?

Наследствена ли е шизофренията?

продава, Четиристаен апартамент, 92 m2 Варна, Победа, 185000 EUR

продава, Четиристаен апартамент, 92 m2 Варна, Победа, 185000 EUR  дава под наем, Магазин, 35 m2 София, Център, бул. Прага, 750 EUR

дава под наем, Магазин, 35 m2 София, Център, бул. Прага, 750 EUR  продава, Тристаен апартамент, 90 m2 Халкидики, 199000 EUR

продава, Тристаен апартамент, 90 m2 Халкидики, 199000 EUR  продава, Къща, 160 m2 Добрич област, с.Лозница, 11000 EUR

продава, Къща, 160 m2 Добрич област, с.Лозница, 11000 EUR  продава, Хотел, 360 m2 Бургас област, гр.Царево, 412000 EUR

продава, Хотел, 360 m2 Бургас област, гр.Царево, 412000 EUR

На повърхността на луната на Юпитер – Европа, е забелязан гигантски черен „паяк“

На повърхността на луната на Юпитер – Европа, е забелязан гигантски черен „паяк“  Лунната почва може да съдържа следи от земната атмосфера

Лунната почва може да съдържа следи от земната атмосфера  Антитела, проектирани от изкуствен интелект, ще бъдат тествани на хора

Антитела, проектирани от изкуствен интелект, ще бъдат тествани на хора  Признаци за бъдеща катастрофа в Антарктида

Признаци за бъдеща катастрофа в Антарктида

Идват коледните банкети: Как да се забавляваш, без да рискуваш кариерата си?

Идват коледните банкети: Как да се забавляваш, без да рискуваш кариерата си?  До дни ще се родят първите бебета, създадени с помощта на изкуствен интелект

До дни ще се родят първите бебета, създадени с помощта на изкуствен интелект  Какви защити имат евробанкнотите и как да разпознаем истинските?

Какви защити имат евробанкнотите и как да разпознаем истинските?  Броят на чужденците в Европа се увеличава, нужни са за работна ръка

Броят на чужденците в Европа се увеличава, нужни са за работна ръка  Какво вещаят звездите за 2026 година?

Какво вещаят звездите за 2026 година?

Ръководството на лекарския съюз получи мандат да подпише нов рамков договор за 2026-2028 г.

Ръководството на лекарския съюз получи мандат да подпише нов рамков договор за 2026-2028 г.  Baidu запълва празнината, която Nvidia остави на пазара на AI чипове в Китай

Baidu запълва празнината, която Nvidia остави на пазара на AI чипове в Китай  Cartier е новият Rolex за поколението Z благодарение на Тейлър Суифт

Cartier е новият Rolex за поколението Z благодарение на Тейлър Суифт  Парижкото споразумение за климата навърши 10 години, но мисията е далеч от изпълнена

Парижкото споразумение за климата навърши 10 години, но мисията е далеч от изпълнена